공부 정리 블로그

선형 SVM 본문

선형 SVM

라그랑제 multipier 도입

선분과 sample 사이에 속하는 margin

각각의 class에 있는 sample들과 만나게 되는 처음 sample => support vector

여백을 가장 크게하는 w를 찾아라 => 최적화 문제

*해의 유일성

아래로 볼록이므로 해는 유일

구한 해는 전역 최적 점 보장

*문제의 난이도

N개의 선형 부등식을 조건으로 가진 2차 함수의 최적화 문제

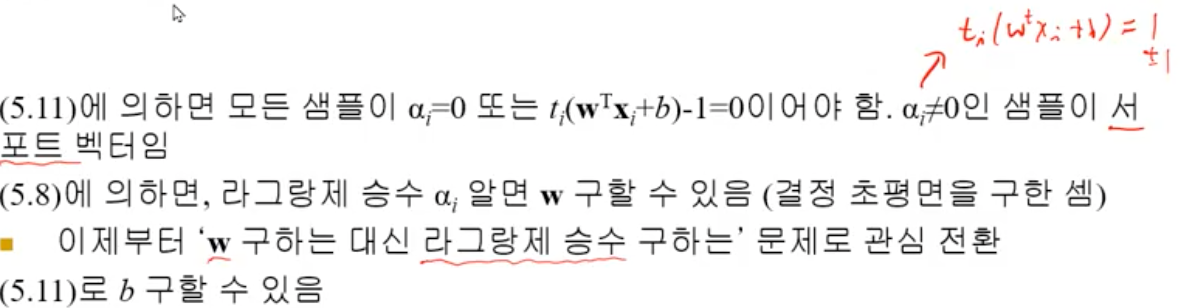

조건부 최적화 문제는 라그랑제 승수로 푼다(lagrange multiplier)

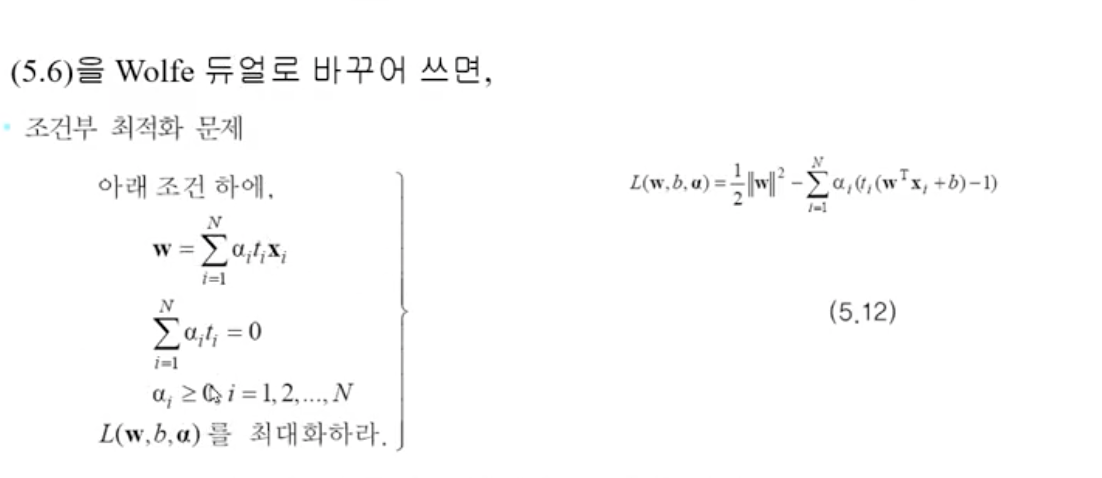

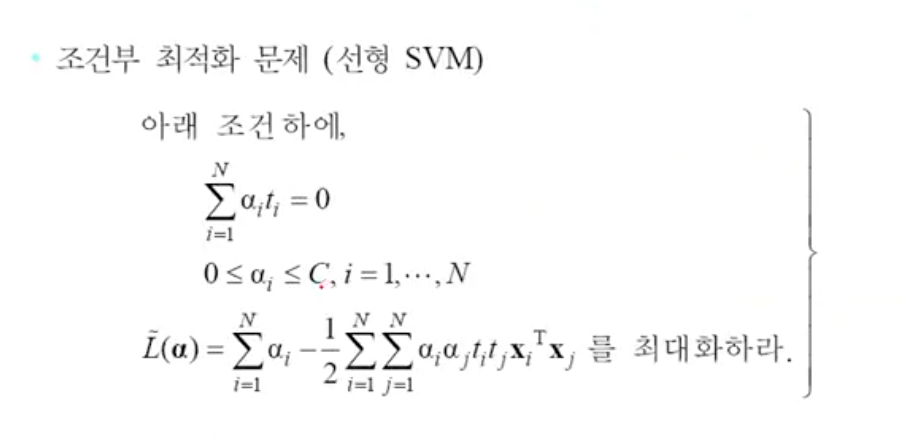

ㅈWolfe 듀얼로 최댓값을 구하는 문제로 변환

=> (x1+x2)**2 = x1x1 + x1x2 + x2x1 + x2x2

=> (a1t1x1 .... antnxn)

1. 최대화 문제로 바뀜 (2차 함수)

2. w와 b 사라짐(라그랑제 a를 찾는 문제가 됨

3. 특징 벡터 x가 내적 형태로 나타남(비선형으로 확장 발판)

4. 목적 함수의 두번째 시그마 항은 N**2개의 항을 갖는다.

지금까지의 과정 정리

예시

x1= (2,3)t , t1 =1

x2 = (4.1)t, t2 = -1

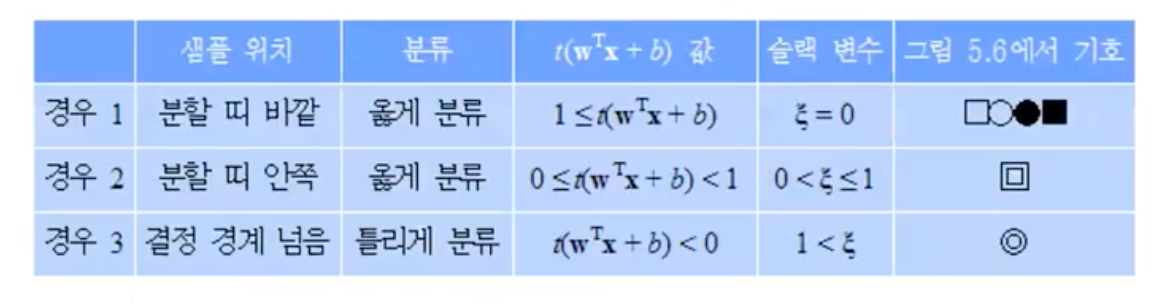

slack 변수 추가하여 식 변형

슬랙 변수를 도입하여 하나의 식으로 표현

C작으면 오분류 허용 ( c-> 0 : error 증가) soft margin

C 크면 오분류 허용 x(c->무한대 : error 허용 줄어듦) hard margin

일반적인 성능을 중요 hard margin : over fiting 이므로 soft margin 이 더 좋은 svm

train 시점에 좋은 성능을 내는 것 보다 test 시 좋은 성능을 내는 것이 더욱 중요 test시점에 오류가 적어지는 방향으로

'대학원 수업 > 패턴인식' 카테고리의 다른 글

| 질적 분류 decision tree (1) | 2022.12.18 |

|---|---|

| 비선형 SVM (0) | 2022.12.18 |

| [1장] 패턴 인식 소개 (0) | 2022.10.23 |

| [2장] 베이시언 결정이론(2/2) - 정규분포 (0) | 2022.10.23 |

| [2장] 베이시언 결정이론(1/2) - 확률기초 ~ 분별 함수 (1) | 2022.10.23 |